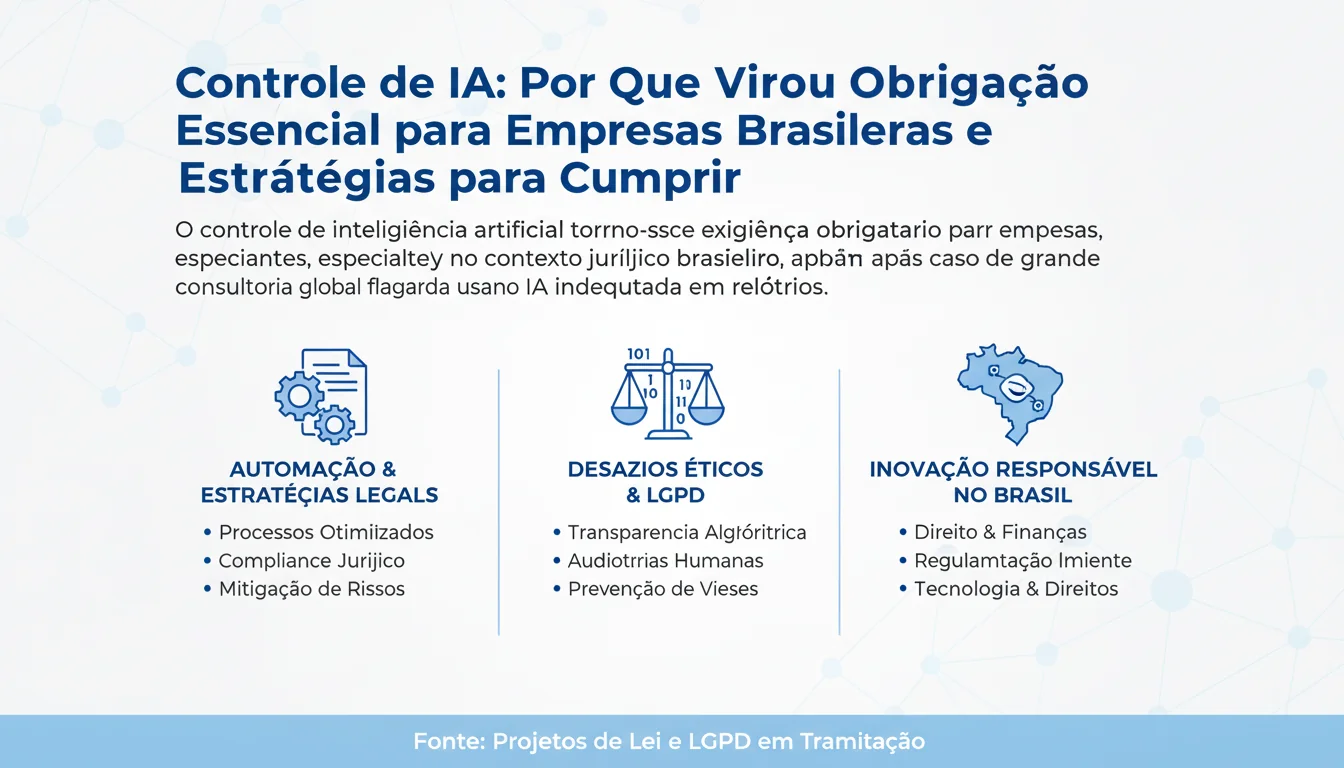

Imagine uma gigante global de consultoria e auditoria, destaque na prestigiada revista Fortune, flagrada em dois países utilizando inteligência artificial de forma inadequada em relatórios cruciais. Esse não é um cenário fictício, mas um alerta real que expõe os riscos de uma tecnologia poderosa quando mal gerenciada. No Brasil, esse episódio reforça uma tendência irreversível: o controle rigoroso de IA não é mais opcional, mas uma exigência para qualquer negócio que queira sobreviver no mercado competitivo de hoje.

A inteligência artificial revolucionou setores como o jurídico, automação de processos e estratégias empresariais, mas trouxe consigo desafios éticos e regulatórios que demandam atenção imediata. No contexto brasileiro, onde a Lei Geral de Proteção de Dados (LGPD) já impõe responsabilidades claras, o uso de IA amplifica esses riscos, especialmente em ambientes sensíveis como o direito. Empresas que ignoram esses controles enfrentam não só multas pesadas, mas também danos irreparáveis à reputação, como visto no caso mencionado pela Consultor Jurídico.

Neste artigo do Blog ConexãoTC, mergulharemos profundamente no porquê o controle de IA se tornou obrigatório, explorando desde os incidentes recentes até as implicações práticas para profissionais de tecnologia e negócios no Brasil. Abordaremos o contexto regulatório global e local, exemplos reais de automação jurídica, desafios éticos e as melhores práticas para implementar governança de IA. Ao final, você sairá equipado com estratégias acionáveis para transformar essa exigência em vantagem competitiva.

Dados impactantes ilustram a urgência: segundo projeções globais, o mercado de IA deve ultrapassar US$ 500 bilhões até 2027, mas 85% das empresas relatam preocupações com ética e conformidade em pesquisas recentes. No Brasil, com a tramitação de projetos de lei específicos para IA no Congresso, como o PL que estabelece marco regulatório, as empresas que não se adaptarem correm o risco de obsolescência regulatória e judicial.

O cerne da notícia, publicada no Consultor Jurídico, gira em torno de um caso emblemático: uma grande empresa de consultoria e auditoria, conhecida mundialmente e citada na Fortune, foi pega utilizando IA de maneira inadequada em relatórios profissionais em dois países. Esse incidente não foi isolado, mas um sintoma de uma prática crescente onde a pressa pela eficiência supera os controles necessários.

No setor jurídico brasileiro, a automação de processos via IA – como análise de contratos, previsão de julgados e geração de peças processuais – tem se popularizado. Porém, sem controle adequado, ferramentas generativas podem inserir erros factuais, vieses ou até alucinações, comprometendo a integridade dos documentos. A exigência agora é clara: toda aplicação de IA deve ser auditável, transparente e supervisionada por humanos responsáveis.

Esse caso destaca a transição de uma era de experimentação para uma de maturidade regulatória. Empresas não podem mais tratar IA como uma caixa-preta; elas precisam mapear riscos, definir políticas internas e treinar equipes. No Brasil, isso se alinha perfeitamente com a LGPD, que exige accountability em tratamentos de dados automatizados, tornando o controle de IA uma extensão natural dessa legislação.

Historicamente, a jornada da IA no contexto jurídico começou com ferramentas simples de busca em jurisprudência nos anos 2000, evoluindo para sistemas de machine learning nos anos 2010. Globalmente, o AI Act da União Europeia, aprovado em 2024, classifica sistemas de IA por risco, proibindo os de alto risco em áreas sensíveis como justiça sem salvaguardas. No Brasil, o debate ganhou força com o Decreto Presidencial de 2023 sobre uso ético de IA em agências federais.

Tecnicamente, o controle envolve governança de IA, que inclui frameworks como MLOps para monitoramento contínuo de modelos. Pense na IA como um motor potente de carro: sem freios e controles (governança), ele pode causar acidentes graves. No mercado brasileiro, players como bancos e fintechs já adotam esses princípios para compliance, evitando sanções da ANPD (Autoridade Nacional de Proteção de Dados).

O impacto principal é na responsabilidade civil e ética. Quando IA falha em um relatório jurídico, quem responde? A empresa desenvolvedora, o usuário ou o algoritmo? Jurisprudência emergente aponta para responsabilidade solidária, mas com ênfase na diligência do operador humano. Para negócios, isso significa custos com auditorias e seguros cibernéticos em ascensão, mas também oportunidades de diferenciação por meio de IA confiável.

Implicações econômicas são vastas: empresas sem controle de IA podem enfrentar multas de até 2% do faturamento global sob LGPD, além de ações judiciais por danos morais. No setor jurídico, advogados que usam IA sem revisão violam o Estatuto da OAB, arriscando sanções éticas. Isso força uma cultura de due diligence, onde tecnologia serve ao humano, não o substitui.

Exemplos práticos abundam. No Judiciário brasileiro, projetos como o LIIARES da ESMAT utilizam IA para eficiência processual, mas com diretrizes éticas rigorosas para transparência e equidade. Escritórios de advocacia em São Paulo empregam IA para pré-elaboração de petições, revisando manualmente para corrigir vieses. Uma fintech brasileira, por exemplo, implementou governança de IA em scoring de crédito, reduzindo discriminações e melhorando conformidade.

Outro caso: plataformas de e-discovery, que analisam milhões de documentos em litígios complexos. Sem controle, elas podem perpetuar vieses de dados de treinamento; com ele, aceleram processos em 70%, como visto em firmas globais adaptadas ao Brasil. Esses casos mostram que controle não é barreira, mas catalisador para inovação segura.

Especialistas em governança de IA, como os da Grant Thornton, enfatizam a proporcionalidade: empresas iniciantes focam em políticas básicas, enquanto maduras integram ética algorítmica com fairness e explicabilidade. No Brasil, advogados como Isabella Talala Zogheib, autora da matéria original, destacam que responsabilidade individual é chave – cada empresa define limites de uso de IA.

Análise aprofundada revela que desafios éticos, como privacidade e não discriminação, são agravados em contextos jurídicos onde decisões afetam liberdades fundamentais. A necessidade de auditorias humanas em outputs de IA generativa é unânime, alinhando-se a princípios do Marco Civil da Internet e Direito do Consumidor. Para profissionais de tech, isso significa upskill em ética de IA.

Tendências apontam para integração de governança no core business. O PL de regulamentação da IA no Brasil, aprovado no Senado e em análise na Câmara, exigirá classificações de risco e relatórios anuais para sistemas de alto impacto. Globalmente, o Executive Order dos EUA reforça testes de segurança, influenciando multinacionais no Brasil.

O que esperar? Aumento de certificações em IA ética, como ISO para governança, e ferramentas nativas de compliance em plataformas como Google Cloud e AWS. Empresas brasileiras que liderarem essa transição, como Nubank em IA responsável, ganharão market share em um ecossistema regulado.

Em resumo, o controle de IA emergiu de incidentes reais para obrigatoriedade estratégica, impulsionado por casos como o da consultoria global e avanços regulatórios no Brasil e mundo. Automação jurídica beneficia eficiência, mas demanda ética e transparência para mitigar riscos.

Olhando ao futuro, empresas ágeis em governança de IA prosperarão, transformando compliance em inovação. Profissionais devem investir em capacitação, preparando-se para um marco regulatório iminente que equilibrará crescimento com proteção de direitos.

Para o mercado brasileiro, isso significa liderança em IA ética na América Latina, com impactos em setores como finanças, saúde e justiça. O Brasil, com sua expertise em dados via LGPD, pode se posicionar como hub regulatório.

Convido você, leitor do ConexãoTC, a avaliar as práticas de IA em sua empresa hoje. Implemente uma política de governança amanhã e transforme risco em oportunidade. Compartilhe nos comentários suas experiências com controle de IA – juntos, navegamos essa revolução tecnológica com segurança e visão estratégica.

Fonte: Consultor Jurídico (https://www.conjur.com.br/2025-dez-13/controle-de-inteligencia-artificial-vira-exigencia-para-negocios/)